Как да защитим данните си от изкуствения интелект и кибератаките

Според него изкуственият интелект застрашава и запазването на самоличността и личния ни живот

Рисковете от активното използване на изкуствен интелект са големи. Той трябва да се развива, но са нужни и строги регулации на глобално ниво. Това каза пред Нова тв експертът по киберсигурност Явор Колев.

„Притеснително е, че не знаем точно докъде са стигнали с развитието на изкуствения интелект в Китай. Има данни, че вече са много напред. В САЩ той също се развива изключително динамично”, каза още Колев. И допълни, че преди седмица Европол предупреди, че този тип нови технологии може да се използва за фишинг атаки и зловреден софтуер. „Това улеснява работата на съвсем неграмотни киберпрестъпници”, заяви още експертът.

Според него изкуственият интелект застрашава и запазването на самоличността и личния ни живот.

„Над 95% от успешните кибератаки се дължат на това, че не прилагат основните правила за киберхигиена. Сред тях са използването на антивирусни програми, сложни пароли, които да са различни за отделните приложения на телефоните и компютрите ни”, обясни Колев.

НС прие по-строги наказания за педофилия и детска порнография

НС прие по-строги наказания за педофилия и детска порнография

Лайза Минели на 80 години - разказва за личния си път, успехите и трудностите

Лайза Минели на 80 години - разказва за личния си път, успехите и трудностите

Откриха тяло на бебе на сметище в Сливен

Откриха тяло на бебе на сметище в Сливен

Община Царево предприе спешни действия заради срутването на алеята в Ахтопол

Община Царево предприе спешни действия заради срутването на алеята в Ахтопол

Задържаха 27-годишна дилърка в Перник

Задържаха 27-годишна дилърка в Перник

Малена Замфирова претърпя нова операция след инцидента в Чехия

Малена Замфирова претърпя нова операция след инцидента в Чехия

Апелативният съд в Бургас посрещна абитуриенти от ПГСАГ „Кольо Фичето“

Апелативният съд в Бургас посрещна абитуриенти от ПГСАГ „Кольо Фичето“

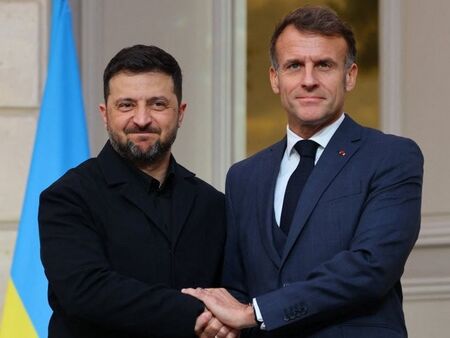

Макрон приема Зеленски в Париж

Макрон приема Зеленски в Париж

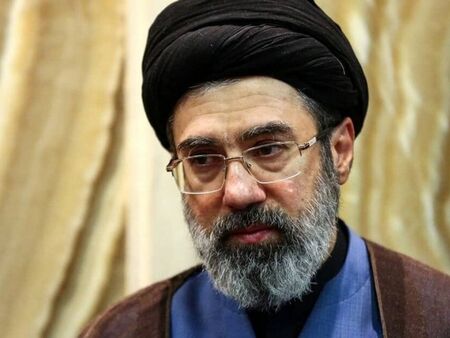

Иран потвърди, че Моджтаба Хаменей е ранен и се укрива на защитено място

Иран потвърди, че Моджтаба Хаменей е ранен и се укрива на защитено място

ТАСС: Израелските железници са атакувани на фона на растящ риск от удари по инфраструктура

ТАСС: Израелските железници са атакувани на фона на растящ риск от удари по инфраструктура

Край на приказката с Никол: Везенков е сингъл

Край на приказката с Никол: Везенков е сингъл